图 1:执行需要精确操作和稳健行走的全身任务的人形机器人。机器人能够:a) 在下半身保持平衡的同时,用手臂跳舞;b) 推着轮椅载着一个人;c) 搬着滑板车行走;d) 使用电梯;e) 收集并丢弃垃圾;f) 打开冰箱,取出并递送一瓶水;g) 将食品储存容器放入微波炉中

图 1:执行需要精确操作和稳健行走的全身任务的人形机器人。机器人能够:a) 在下半身保持平衡的同时,用手臂跳舞;b) 推着轮椅载着一个人;c) 搬着滑板车行走;d) 使用电梯;e) 收集并丢弃垃圾;f) 打开冰箱,取出并递送一瓶水;g) 将食品储存容器放入微波炉中I.引言

我们在运动中精准抓取物体的能力是日常生活中必不可少的一部分。在人形机器人控制中,对手臂的需求与对双腿的需求大不相同:我们希望手臂具有足够的灵活性,能够施加不同的力,固定物体在某一位置,并快速移动,例如接住一个球。同时,双腿需要保持平衡,比如在搬运箱子时行走,或在运球时奔跑。然而,现有最先进的人形机器人全身控制技术尚无法实现这些功能。关键问题在于,如何将上半身的灵活与承载性动作,与下半身对常见运动范围的控制有机结合起来。 最近,全身人形机器人控制领域通过强化学习(RL)取得了一些进展,展示了机器人能够从大规模人类运动数据集[4]或远程操控[5][6]中,稳健地执行各种运动[1]–[3]。在这种方法中,RL 通常让机器人在仿真环境中面对多种目标运动和失败模式,从而产生可以直接应用于现实世界的高性能策略。然而,这种方法以牺牲表达能力为代价,因为 RL 往往会趋向并过拟合于某些模式。此外,RL 策略对于高自由度(DoF)的姿态和方向控制并不适用[7][8],特别是在动态行走场景中,可能会导致手臂产生不可预测的动作,并增加训练复杂度。这些实验结果与我们的观察一致,即上肢和下肢需要不同的控制机制。

上半身运动可以通过逆向运动学(IK)高效计算,无需处理复杂的平衡问题。因此,我们提出在 RL 训练中去除上半身的运动追踪,让 RL 控制器仅负责基于速度命令实现稳健的行走。这种方法降低了探索和训练成本,同时通过直接的关节位置控制确保了上半身的高精度。

尽管上下肢分离控制能提高操作精度,先前研究[2][3][8]表明,完全分离上下肢控制可能导致不稳定或失衡,因为未能考虑两者之间的相互作用。本研究的目标是开发一种集成系统,将经典运动规划中上肢的精准与表达能力,与通过深度强化学习训练的下肢运动控制的现实世界稳健性结合起来。我们将此问题视为一个表示学习问题,首先通过条件变分自编码器(CVAE)学习上半身运动的预测先验(PMP),将其编码为策略的观察输入。具体而言,我们首先在运动数据集上训练一个 CVAE。基于过去的运动帧,CVAE 的解码器通过随机采样的潜在向量预测未来的运动帧。接下来,我们训练一个 RL 行走策略,将潜在向量作为观察输入。RL 策略的输出仅涉及下肢电机,上肢的电机角度则可以通过 IK 或运动重定向以通用方式设定,从而实现更高精度。

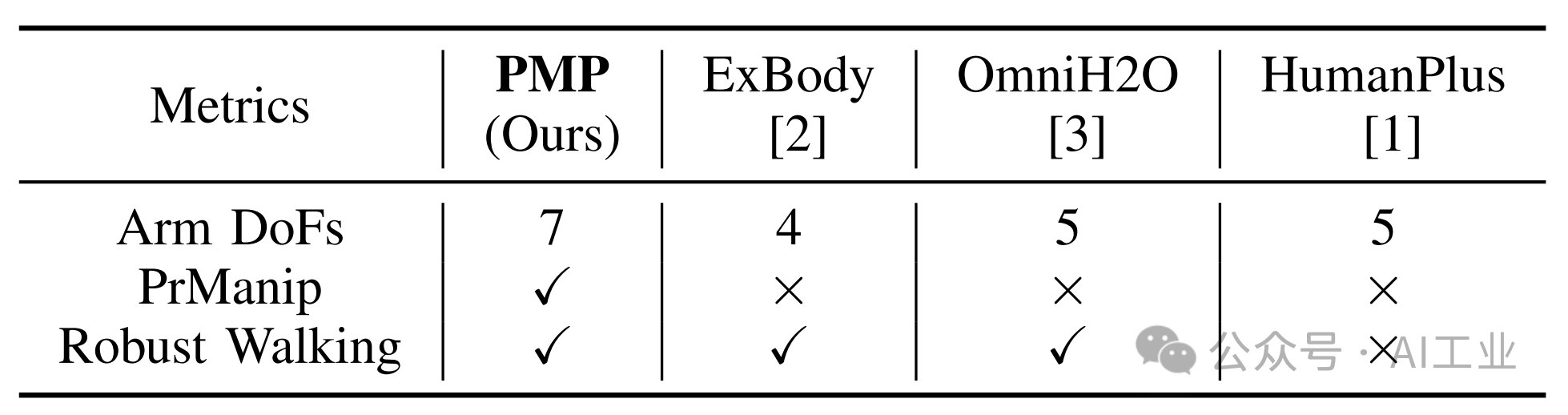

这种分离结构尤其适合于为移动操控任务设计的远程操作系统,其中操作者可以通过简单的速度命令控制机器人的移动,同时进行精准的手臂和手部操作。通过利用 IK 和手部重定向,远程操作者可以高效完成复杂的操控任务,而无需关注平衡或下肢协调。如图1所示,这种方法使机器人在移动过程中能够更高效地执行精细、动态且承载性的操控任务。我们在表1中详细比较了该方法与以往方法。

最近,全身人形机器人控制领域通过强化学习(RL)取得了一些进展,展示了机器人能够从大规模人类运动数据集[4]或远程操控[5][6]中,稳健地执行各种运动[1]–[3]。在这种方法中,RL 通常让机器人在仿真环境中面对多种目标运动和失败模式,从而产生可以直接应用于现实世界的高性能策略。然而,这种方法以牺牲表达能力为代价,因为 RL 往往会趋向并过拟合于某些模式。此外,RL 策略对于高自由度(DoF)的姿态和方向控制并不适用[7][8],特别是在动态行走场景中,可能会导致手臂产生不可预测的动作,并增加训练复杂度。这些实验结果与我们的观察一致,即上肢和下肢需要不同的控制机制。

上半身运动可以通过逆向运动学(IK)高效计算,无需处理复杂的平衡问题。因此,我们提出在 RL 训练中去除上半身的运动追踪,让 RL 控制器仅负责基于速度命令实现稳健的行走。这种方法降低了探索和训练成本,同时通过直接的关节位置控制确保了上半身的高精度。

尽管上下肢分离控制能提高操作精度,先前研究[2][3][8]表明,完全分离上下肢控制可能导致不稳定或失衡,因为未能考虑两者之间的相互作用。本研究的目标是开发一种集成系统,将经典运动规划中上肢的精准与表达能力,与通过深度强化学习训练的下肢运动控制的现实世界稳健性结合起来。我们将此问题视为一个表示学习问题,首先通过条件变分自编码器(CVAE)学习上半身运动的预测先验(PMP),将其编码为策略的观察输入。具体而言,我们首先在运动数据集上训练一个 CVAE。基于过去的运动帧,CVAE 的解码器通过随机采样的潜在向量预测未来的运动帧。接下来,我们训练一个 RL 行走策略,将潜在向量作为观察输入。RL 策略的输出仅涉及下肢电机,上肢的电机角度则可以通过 IK 或运动重定向以通用方式设定,从而实现更高精度。

这种分离结构尤其适合于为移动操控任务设计的远程操作系统,其中操作者可以通过简单的速度命令控制机器人的移动,同时进行精准的手臂和手部操作。通过利用 IK 和手部重定向,远程操作者可以高效完成复杂的操控任务,而无需关注平衡或下肢协调。如图1所示,这种方法使机器人在移动过程中能够更高效地执行精细、动态且承载性的操控任务。我们在表1中详细比较了该方法与以往方法。 表 I:全身控制方法的比较 PrManip 表示手臂动作是否直接受控,而不经过强化学习(RL)映射。Robust walking 表示工作是否展示了机器人至少 10 秒的行走稳健性。

表 I:全身控制方法的比较 PrManip 表示手臂动作是否直接受控,而不经过强化学习(RL)映射。Robust walking 表示工作是否展示了机器人至少 10 秒的行走稳健性。

为了验证方法的通用性,我们在仿真中以 Fourier GR1 和 Unitree H1 机器人为实验对象,并在实际中评估了 Unitree 的控制器。我们通过机器人在远程操作中承载各种负载的大幅运动测试其稳健性(图1)。实验结果展示了 PMP 能够实现高自由度手臂的精准上肢控制,同时保持稳健性,这是以往方法中未曾见过的新能力。

II.问题定义

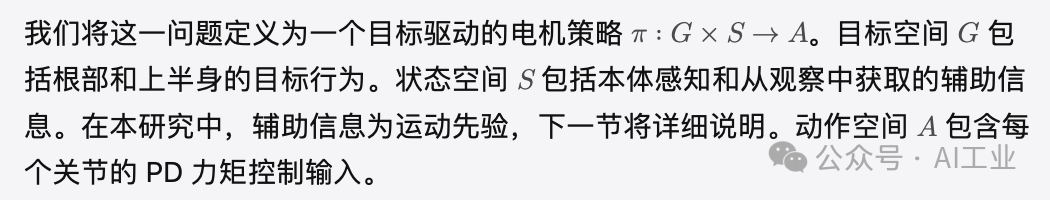

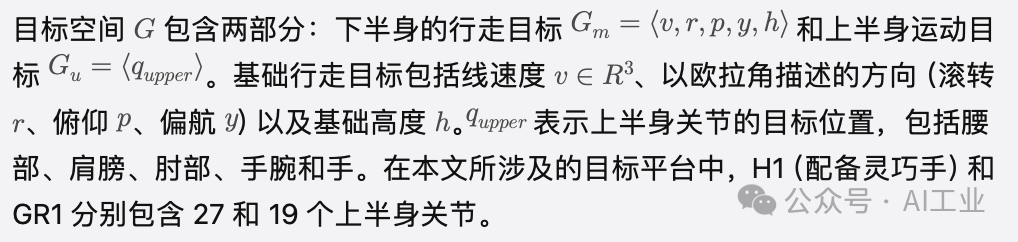

我们专注于设计一种下半身控制器,该控制器能够在上半身执行动态动作时,追踪给定的身体速度并保持稳定。 a) 行走控制与上半身运动的目标空间:

a) 行走控制与上半身运动的目标空间: b) 解耦控制策略:

b) 解耦控制策略: III.方法

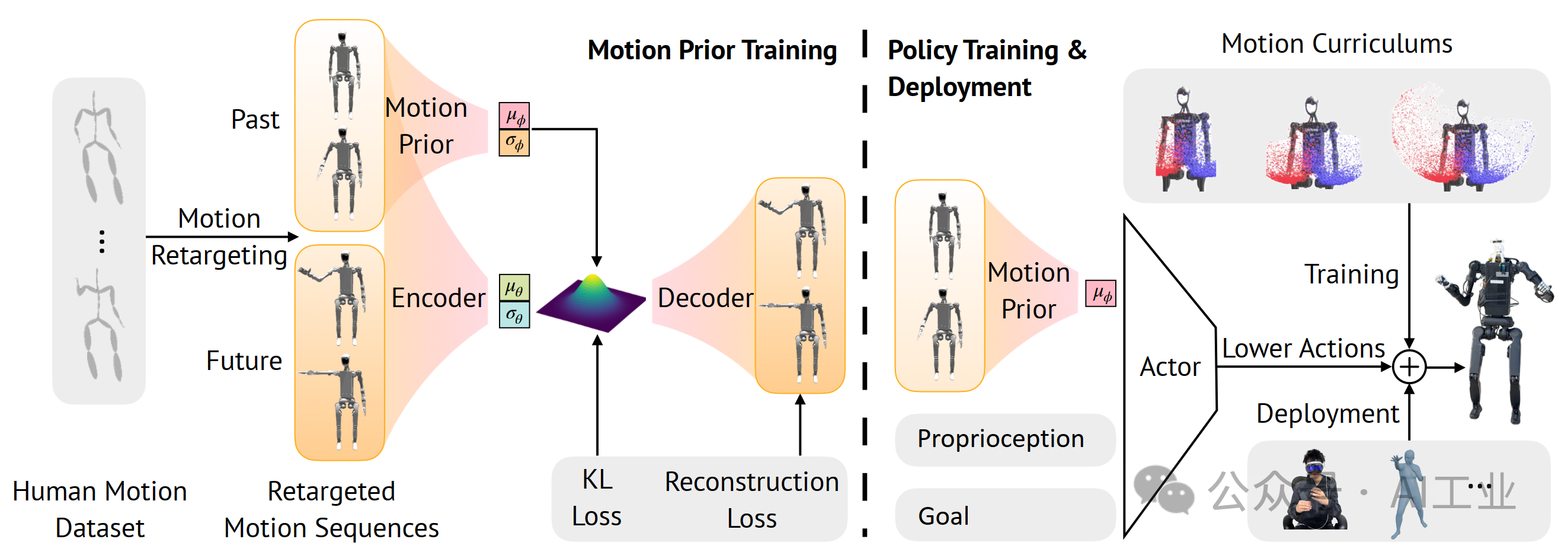

III.方法 图 2:训练流程包括三个阶段:(a) 通过映射局部旋转对运动数据集进行预处理;(b) 训练条件变分自编码器(CVAE)以捕获上半身人类运动的先验知识;(c) 使用采样的目标关节位置控制上半身,同时通过先验运动表示训练下半身的强化学习(RL)。

图 2:训练流程包括三个阶段:(a) 通过映射局部旋转对运动数据集进行预处理;(b) 训练条件变分自编码器(CVAE)以捕获上半身人类运动的先验知识;(c) 使用采样的目标关节位置控制上半身,同时通过先验运动表示训练下半身的强化学习(RL)。

如图 2 所示,我们的训练流程包含三个阶段。第一阶段是对给定的人体运动数据集进行预处理,其中通过局部旋转映射将局部旋转矩阵转换为机器人上的关节角度。我们遵循 ExBody [2] 中描述的数据过滤和重定向过程,得到一个重定向后的运动数据集。第二阶段,我们基于重定向后的数据集训练模型,以自回归方式生成未来的运动序列。生成的运动序列随后用于提取运动先验(Motion Priors),其具体内容将在 III-A 节中详细介绍。第三阶段,我们直接在课程式调度中使用采样的目标关节位置来控制上半身,并将其与下半身控制相结合,实现全身运动。

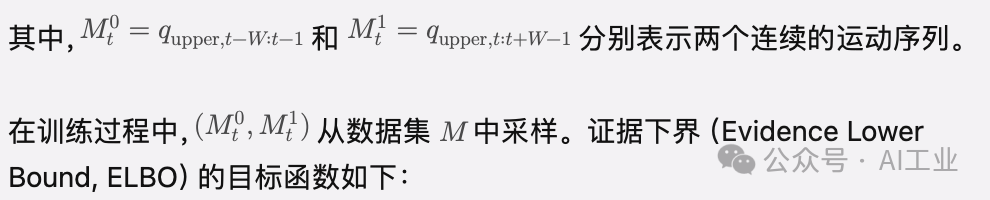

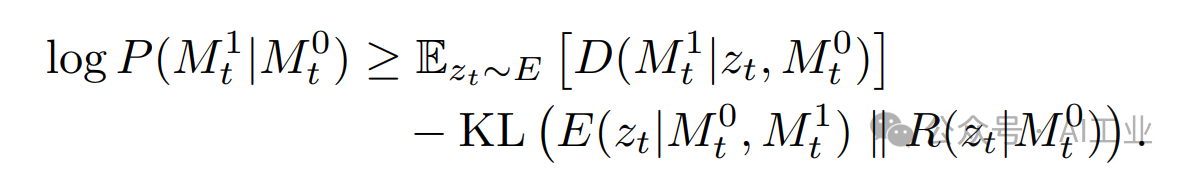

A.运动先验训练

由于我们的控制策略将上半身和下半身分离,下半身控制在上半身控制具有独立策略时的稳健性尤为重要。解决这一挑战的关键在于为下半身控制提供关于上半身运动的先验知识。具体而言,我们基于重定向数据集估计上半身的未来运动轨迹,并训练一个可在下半身控制的状态空间中使用的表示形式。我们将这种表示定义为预测运动先验(Predictive Motion Priors,PMP)。

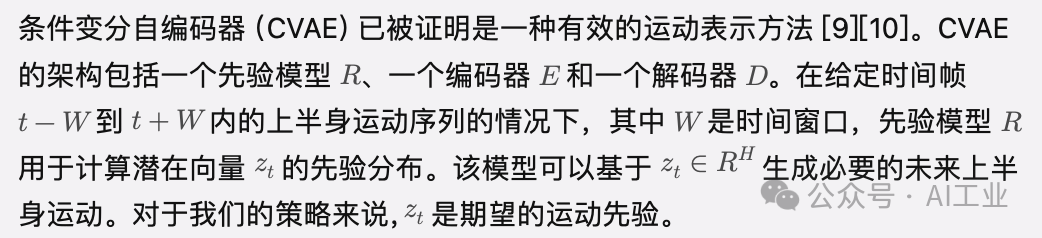

形式化地,我们将编码器和先验分布建模为对角高斯分布:

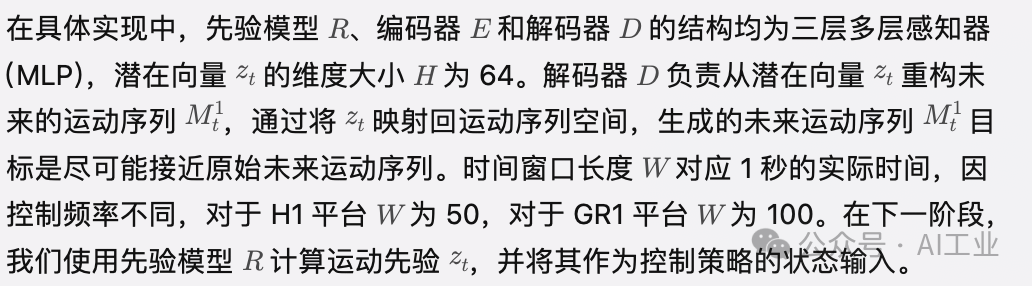

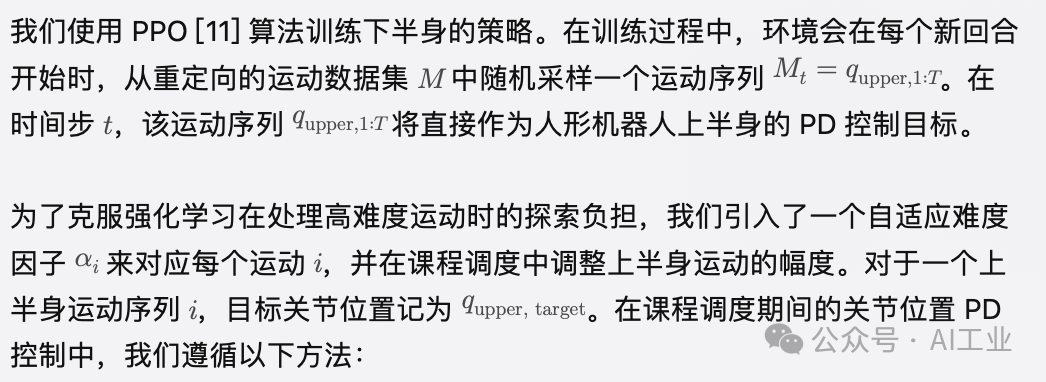

B.解耦策略训练

B.解耦策略训练

我们参考 ExBody [2] 的奖励设计,并额外加入了显式的步态周期性奖励,这在之前的研究 [12][13] 中有所体现。

IV.实验

我们在真实世界实验中使用了 Unitree H1 机器人,并在仿真实验中额外使用了 Fourier GR-1 机器人。H1 机器人的详细信息如图 4 所示。通过仿真和真实世界的实验,我们旨在回答以下问题:

1.与基于学习的上半身控制方法相比,PMP 的性能如何?

2.当出现扰动时,PMP 的跟踪精度和稳定性如何?

3.在需要同时实现稳健行走和精确操作的真实场景中,PMP 的表现如何?

A.仿真实验结果

为了在仿真中回答问题 Q1,我们通过以下基线方法评估 PMP 的性能:

我们参考 ExBody [2] 的奖励设计,并额外加入了显式的步态周期性奖励,这在之前的研究 [12][13] 中有所体现。

IV.实验

我们在真实世界实验中使用了 Unitree H1 机器人,并在仿真实验中额外使用了 Fourier GR-1 机器人。H1 机器人的详细信息如图 4 所示。通过仿真和真实世界的实验,我们旨在回答以下问题:

1.与基于学习的上半身控制方法相比,PMP 的性能如何?

2.当出现扰动时,PMP 的跟踪精度和稳定性如何?

3.在需要同时实现稳健行走和精确操作的真实场景中,PMP 的表现如何?

A.仿真实验结果

为了在仿真中回答问题 Q1,我们通过以下基线方法评估 PMP 的性能:

•ExBody:该基线的上半身控制策略通过 RL 训练,使用上半身目标关键点和关节位置的跟踪奖励。H1 的代码来源于 ExBody [2] 的代码库,GR1 的代码基于我们的重新实现。 •ExBody(全身):该基线的上半身控制策略通过 RL 训练,使用全身目标关键点和关节位置的跟踪奖励。H1 的代码来源于 ExBody 的代码库,类似方法包括 HumanoidPlus [1] 和 OmniH2O [3],它们的奖励设置和 RL 训练方式相似。

•没有运动先验的 PMP:该基线使用了解耦策略,但未包含运动先验。

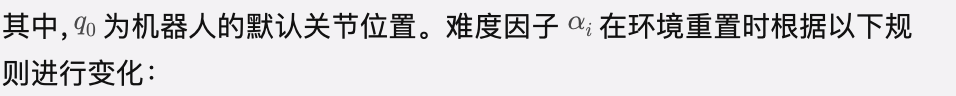

•没有运动课程的 PMP:这是关于运动课程的消融研究。在该基线中,运动课程中的 始终设置为 1。

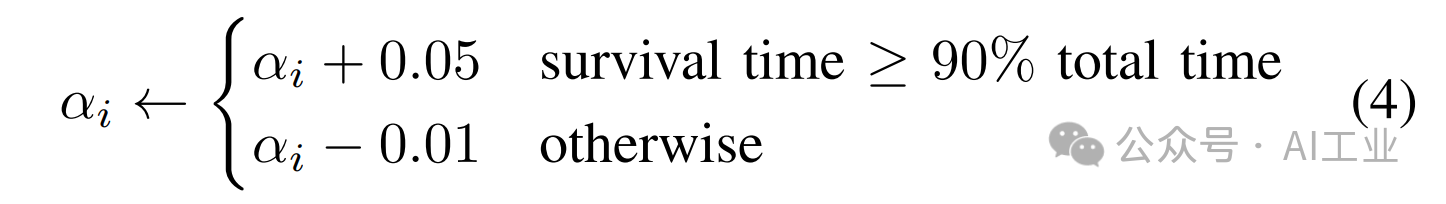

我们的评估指标如下:

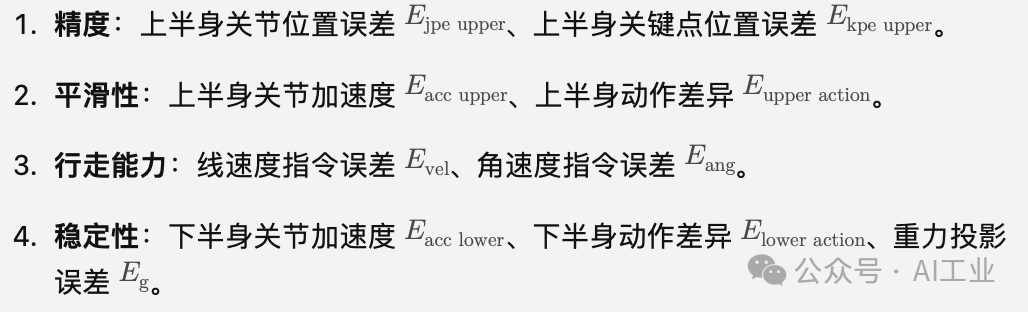

表 II:与基线方法的比较 我们在仿真中从数据集中为每种运动采样 5 条轨迹,并报告其平均回合指标。行走指令基于相应运动的基础状态生成。

表 II:与基线方法的比较 我们在仿真中从数据集中为每种运动采样 5 条轨迹,并报告其平均回合指标。行走指令基于相应运动的基础状态生成。

结果如表 II 所示。我们观察到,与基于可学习策略的上半身控制相比,采用本文提出的解耦方法的控制策略在上半身运动目标的跟踪精度和平滑性方面显著提高。对于行走能力和稳定性,H1 的实验结果显示,解耦策略在运动指令跟踪和下半身稳定性方面的性能指标有所下降,这是行走与操控(loco-manipulation)任务中常见的权衡结果。然而,PMP 通过利用运动先验和运动课程显著改善了下半身的稳定性,其性能指标与最佳基线方法相当。 图 3:在扰动条件下的精度(顶部)和稳定性(底部)评估(数值越低越好)。我们在仿真中从运动数据集中为每种运动采样 5 条轨迹,并报告每种扰动类型的平均回合指标。行走指令基于相应运动的基础状态生成。机器人每 5 秒会受到一次推力扰动,其表现为速度突然增加到推力速度的值。运动速度通过将重定向运动的帧速率乘以相应因子进行改变。PMP 显示更低的数值,对应更好的性能。

图 3:在扰动条件下的精度(顶部)和稳定性(底部)评估(数值越低越好)。我们在仿真中从运动数据集中为每种运动采样 5 条轨迹,并报告每种扰动类型的平均回合指标。行走指令基于相应运动的基础状态生成。机器人每 5 秒会受到一次推力扰动,其表现为速度突然增加到推力速度的值。运动速度通过将重定向运动的帧速率乘以相应因子进行改变。PMP 显示更低的数值,对应更好的性能。

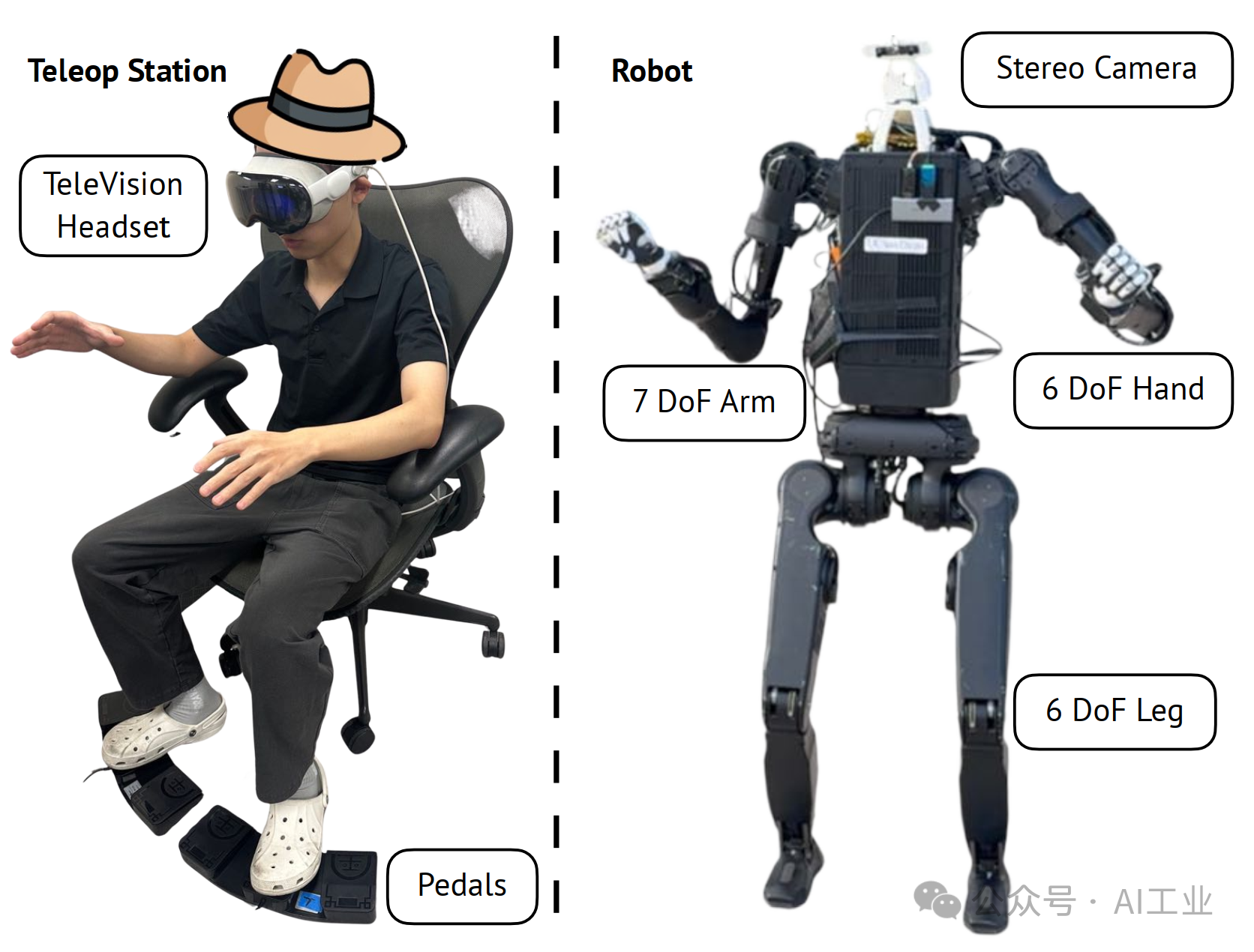

B.远程操作设置

为了测试我们方法在现实世界中的性能,我们基于 Unitree H1 机器人建立了一个真实世界的远程操作系统。上半身和主动颈部的远程操作遵循 [5] 中描述的流程。操作员通过 Apple Vision Pro 设备跟踪手部和头部运动,这些运动通过逆向运动学(IK)和运动重定向转化为机器人的关节角度。立体摄像头的视频流以实时方式传输到 VR 头显,提供沉浸式显示。

对于下半身控制,由于我们的策略将(线速度、滚转、俯仰、偏航和高度)作为行走目标,因此兼容任何能够提供这些指令的输入设备。我们的系统为行走控制提供了两种不同的远程操作设置:

1.分离控制:一个操作员通过 VR 头显控制上半身,另一个操作员通过带操纵杆的遥控器控制下半身。 图 4:左图:统一的远程操作设置,单个用户通过 Apple Vision Pro 控制上半身,并通过脚踏板发送下半身行走指令。右图:带有定制颈部和头部的 H1 机器人。每只手臂安装了一个 6 自由度的灵巧手。主动颈部和立体摄像头用于沉浸式远程操作,参考文献 [5]。

图 4:左图:统一的远程操作设置,单个用户通过 Apple Vision Pro 控制上半身,并通过脚踏板发送下半身行走指令。右图:带有定制颈部和头部的 H1 机器人。每只手臂安装了一个 6 自由度的灵巧手。主动颈部和立体摄像头用于沉浸式远程操作,参考文献 [5]。

2.统一控制:一个操作员同时控制上半身和下半身。上半身通过 VR 头显控制,下半身通过脚踏板控制,如图 4 左侧所示。这种统一的设置允许单个用户实现对整个机器人的人形远程操作。 我们的远程操作系统能够执行多样化的行走与操作(loco-manipulation)任务,如图 1 所示。

C.真实世界实验结果

为了回答问题 Q3,我们通过实验评估了行走的稳健性和操作的精确性。

1.稳健性测试: 图 5:稳健性测试。左图:机器人在站立时受到推力;右图:机器人恢复到稳定的站立姿态。

图 5:稳健性测试。左图:机器人在站立时受到推力;右图:机器人恢复到稳定的站立姿态。

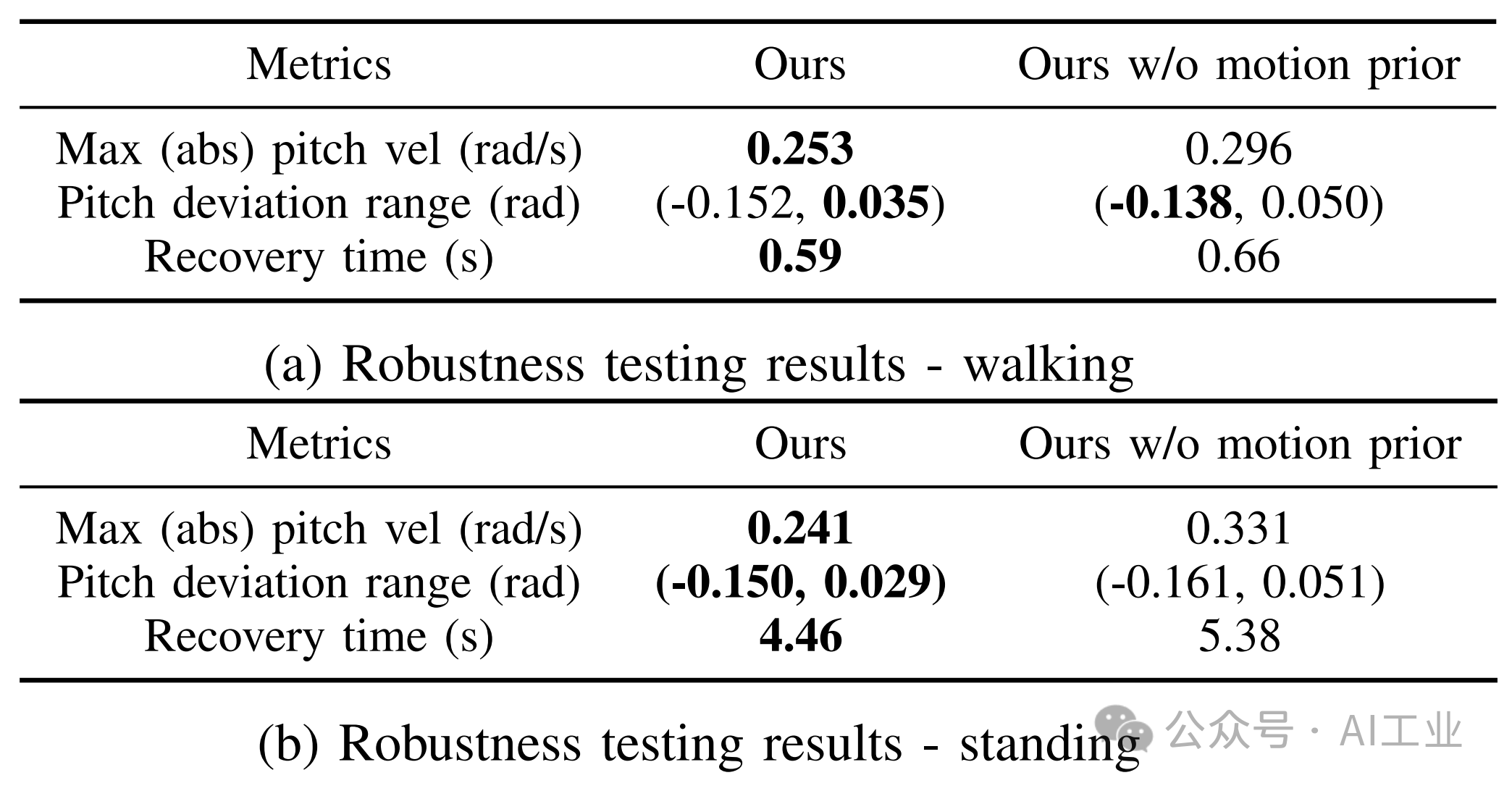

为验证我们方法在行走控制中的稳定性,我们进行了稳健性测试,如图 5 所示。通过向机器人躯干施加推力,评估其稳健性,测量最大俯仰速度、最大俯仰偏差以及恢复时间。测试的策略包括“我们的方法(PMP)”和“我们的方法(PMP,无运动先验)”。我们分别针对行走模式和站立模式展示了稳健性测试结果,如表 III 所示。 表 III:稳健性测试结果 每个数值取自十次推力测试的平均值。恢复时间表示机器人在能够再次稳步行走或站立在固定位置前所需的时间。

表 III:稳健性测试结果 每个数值取自十次推力测试的平均值。恢复时间表示机器人在能够再次稳步行走或站立在固定位置前所需的时间。

当机器人在行走时受到推力,两种策略在恢复至稳定状态方面表现相当;而在站立时受到推力,使用运动先验训练的策略展现出更小的稳定姿态偏差,并且恢复时间更短。站立模式下的恢复过程通常比行走模式更长,因为机器人在初期无法找到稳定的腿部位置时,可能需要额外采取几步进行调整和稳定。引入运动先验的策略显著减少了这种情况的发生频率和持续时间。

2.精确性评估: 表 IV:手臂跟踪误差 对于每个任务,误差取 20 条轨迹的平均值,相当于在 50 Hz 控制频率下约 30 分钟的手臂运动数据。

表 IV:手臂跟踪误差 对于每个任务,误差取 20 条轨迹的平均值,相当于在 50 Hz 控制频率下约 30 分钟的手臂运动数据。

我们通过测量跟踪目标(由 Apple Vision Pro 追踪的左右手腕位置)与机器人手腕实际位置之间的距离,评估我们方法在手臂跟踪中的精确性。由于没有准确的动作捕捉设备,直接测量真实世界的手腕位置具有难度,因此我们基于手臂电机读数通过正向运动学计算手腕位置。跟踪距离的评估结果如表 IV 所示,数据来自机器人执行 [5] 中描述的四个桌面任务的轨迹。

结果表明,我们的系统能够紧密跟踪人类手腕的运动。值得注意的是,人类手腕位置与机器人关节角度之间存在两层平滑操作:一个应用于手腕位置的线性滤波器和 PD 控制器。此外,跟踪误差还可能因与物体的交互而被放大。尽管存在这些影响因素,我们的系统始终保持较低的跟踪误差。

V.相关工作 人形机器人的全身控制

为了让人形机器人更有用,它们需要在移动性上具有稳健性,同时在操作上具有精确性。以往主要通过动力学建模和控制[14]-[27]实现这些目标。近年来,深度强化学习方法在学习四足机器人复杂行走技能方面展现了潜力[8], [28]-[46]。基于高维感知输入的全身行走与操作(loco-manipulation)研究已覆盖四足机器人[8], [47]-[49]和人形机器人[1]-[3], [32], [50], [51]。在[1]-[3]中,作者训练了全身策略,输出整个身体的动作以实现稳健性。[2] 解耦了上下肢的目标,以弥补人类与机器人形态学的差异。[1] 使用一个 transformer 进行人形机器人全身控制,另一个 transformer 用于模仿学习。[3] 则针对各种下游任务训练了目标驱动策略。然而,这些研究聚焦于较小手臂自由度(4 或 5)的全身控制,并未深入研究上半身精度对操作的影响。

行走与操作(Loco-Manipulation)

四足机器人可以通过腿进行操作[48], [52]-[55],或者安装额外的操控臂[7], [8], [49], [56], [57]。人形机器人天然地拥有两条手臂用于操作,两条腿用于行走。[58] 使用分层视觉-运动策略与隐式分层全身控制来进行精细操作。然而,其未能展示在现实环境中稳健行走的能力,且重点放在静态操作上。[59] 研究了如何通过模拟到现实技术完成箱体行走与操作任务,但缺乏对多种任务的泛化能力。

运动表示学习

人类和机器人的运动处于高维时空空间中。良好的运动表示有助于运动理解、生成和模仿。对抗模仿方法(如[60]-[63])在小规模运动数据集上表现良好,但在运动数据规模扩大时容易发生模式崩塌。[64]-[67] 使用条件变分自编码器(CVAE)在仿真中学习可重用的运动表示,用于生成新颖的运动。然而,如何使用 CVAE 协调真实人形机器人的全身运动尚未得到充分研究。

VI.讨论与局限性

本文提出了一种新颖的人形机器人全身控制器,通过逆向运动学(IK)和运动重定向分别建模上半身,并使用强化学习(RL)控制下半身。为了实现上下肢之间的稳健控制,我们引入了预测运动先验(Predictive Motion Priors),将上半身信息编码用于下半身 RL 训练。我们在仿真、真实机器人全身控制以及远程操作实验中展示了优越的性能。

尽管我们的方法使人形机器人能够完成多种行走与操作任务,但上下肢控制的分离限制了机器人完成某些高灵活性任务的能力。然而,目前的人形机器人硬件相较于人类的自由度仍然过少,这使得通过 RL 实现灵活的全身运动跟踪在实际中具有极大挑战性。此外,全身策略需要接受多种输入命令(如前进/横向速度和偏航速度),这给人类远程操作者带来了负担,因为手臂和手的动作需要映射到机器人的手臂和手的控制。我们需要一个更好的人与机器人交互界面来解决这些问题。

京公网安备11010502056287号

京公网安备11010502056287号